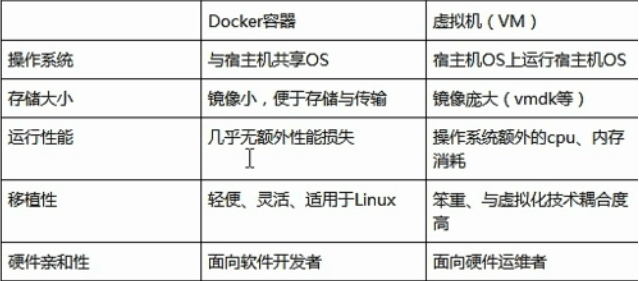

最小二乘法是一种数学优化技术,用于求解线性回归问题。

它通过最小化预测值与观察值之间的平方误差和来找到回归线。

![最小二乘法python(使用Python重构最小二乘法的实现方案) 图片[1]-最小二乘法python(使用Python重构最小二乘法的实现方案)-不念博客](https://www.bunian.cn/wp-content/uploads/2023/04/qqjietu20230430171628.png)

以下是使用Python重构最小二乘法的示例:

import numpy as np

def least_squares(X, y):

# 计算X的转置

X_transpose = np.transpose(X)

# 计算(X^T * X)的逆

XTX_inverse = np.linalg.inv(np.dot(X_transpose, X))

# 计算 (X^T * X)^(-1) * X^T * y

w = np.dot(np.dot(XTX_inverse, X_transpose), y)

return w

# 示例数据

X = np.array([[1, 1], [1, 2], [1, 3], [1, 4]])

y = np.array([3, 5, 7, 9])

# 计算回归系数

coefficients = least_squares(X, y)

print("回归系数:", coefficients)在这个示例中,我们定义了一个名为least_squares的函数,它接受两个参数:一个包含输入数据(特征)的矩阵X和一个包含目标数据的向量y。

请注意,我们在X矩阵中添加了一列全为1的偏置项,以便求解线性回归的截距。

我们使用NumPy库进行矩阵运算,首先,我们计算X的转置矩阵。

接着,我们计算(X^T * X)的逆矩阵。

最后,我们计算(X^T * X)^(-1) * X^T * y以获得回归系数。

在这个示例中,我们使用了一个简单的线性回归问题,可以根据需要修改输入数据和目标数据以求解更复杂的回归问题。

© 版权声明

本站文章由不念博客原创,未经允许严禁转载!

THE END